GTX1050Ti显卡搭载了CUDA架构,这一设计使得GPU具备了卓越的并行计算能力。它能有效提升各类计算密集型任务的执行速度。无论是在深度学习、图形处理还是科学计算等众多领域,GTX1050Ti都发挥着显著的作用。接下来,我们将对GTX1050Ti的CUDA特性进行详细介绍。

CUDA架构基础

CUDA是NVIDIA开发的一个并行计算平台和编程框架。借助这个平台,开发者能够利用GPU的并行处理功能来进行计算。以GTX1050Ti为例,它配备了专门的CUDA核心,这些核心如同众多小计算员,能够同时执行多项任务,从而显著提升了计算的速度。借助CUDA技术,开发者能够使用C、C++、Fortran等编程语言来编写并行程序,进而通过调动GPU上成千上万个核心,实现高效计算。

借助CUDA的并行编程架构,开发者能够将计算任务细分为众多并行执行的线程块,每个线程分担一部分计算工作。在图形渲染领域,庞大的场景可以被划分为众多小区域,每个小区域由一个线程负责处理,从而实现渲染任务的快速且高效完成。

GTX1050Ti CUDA特性

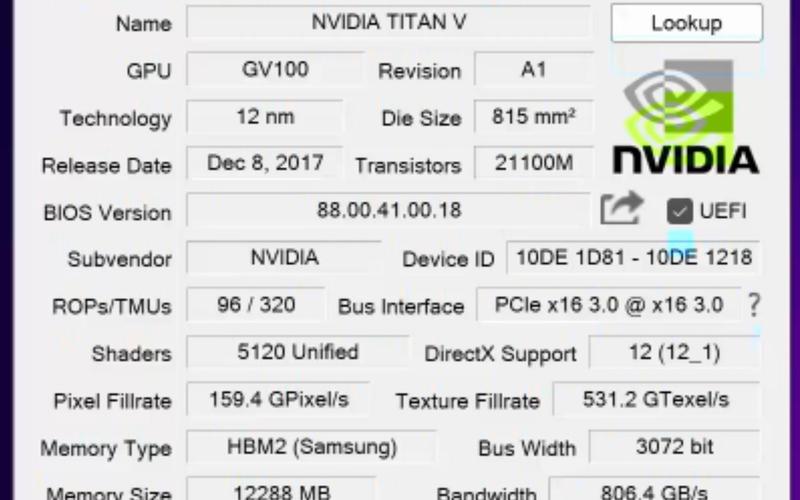

GTX1050Ti配备了768个CUDA核心,这个数量并不算少。它足以应对众多常见的并行计算任务。此外,其显存带宽和核心频率与CUDA的配合,使得数据处理效率得到显著提升。GTX1050Ti还具备CUDA的多项特性,例如纹理映射单元、只读和读写缓存等。这些特性不仅能够加速数据的读写和处理,还能降低CPU与GPU之间的数据传输延迟,从而提升整体性能。

在科研领域,进行数值模拟和数据分析往往需要大量的计算资源。GTX1050Ti显卡凭借其CUDA技术,能够高效地完成这些计算任务,从而使得研究人员能够更快地获得所需结果。以分子动力学模拟为例,借助CUDA的加速功能,我们能够模拟更大规模的分子系统,并提升模拟的精确度。

应用领域拓展

在深度学习领域,GTX1050Ti显卡的CUDA功能非常实用。众多深度学习框架,包括TensorFlow和PyTorch等,都具备CUDA加速训练和推理的能力。对于猫狗等简单的图像分类任务,配备CUDA的GTX1050Ti显卡可以显著提升模型训练的效率,缩短训练所需的时间。

在视频处理这一领域,CUDA技术能够显著提升视频的编码、解码以及转码效率。在日常生活中,当我们进行视频剪辑或格式转换时,选用支持CUDA功能的软件,可以大大缩短操作时间。同样,在制作动画和影视特效时,借助CUDA核心的加速功能,可以提升渲染速度,并保证画面质量更加出色。

驱动和环境配置

为了充分利用GTX1050Ti CUDA的性能,安装适当的驱动程序并正确配置CUDA环境是关键。首先,需至NVIDIA官方网站下载并安装最新的显卡驱动,这样能更有效地与显卡硬件协同工作,提升CUDA的性能表现。然后,安装CUDA Toolkit,不同版本的Toolkit有不同的需求和特性,用户应根据自己的需求挑选合适的版本。

安装CUDA成功后,必须对相应的开发环境进行配置。以Windows系统为例,需正确设置环境变量,确保编译器和程序能够准确识别CUDA的相关库和工具。一旦完成配置,编译和执行代码时便无需重复设置,程序便能直接调用CUDA,实现高效计算。

性能优化技巧

运用GTX1050Ti CUDA进行编程时,算法优化至关重要。需挑选恰当的并行算法,并妥善配置线程与线程块的数量,这有助于提升GPU的利用率。同时,合理规划数据的存储与访问方式,也能有效提升计算效率。通过共享内存来存储中间数据,可以降低对全局内存的访问频率,进而减少内存访问的延迟。

优化内存的合并式访问确实十分关键。当进行全局内存访问时,若能让邻近的线程访问连续的内存地址,这有助于提升内存带宽的使用效率。然而,在并行执行的线程中,过多的同步操作会拖慢性能,因此我们应尽量减少不必要的同步,以便线程可以独立地完成各自的计算任务。

发展与局限性

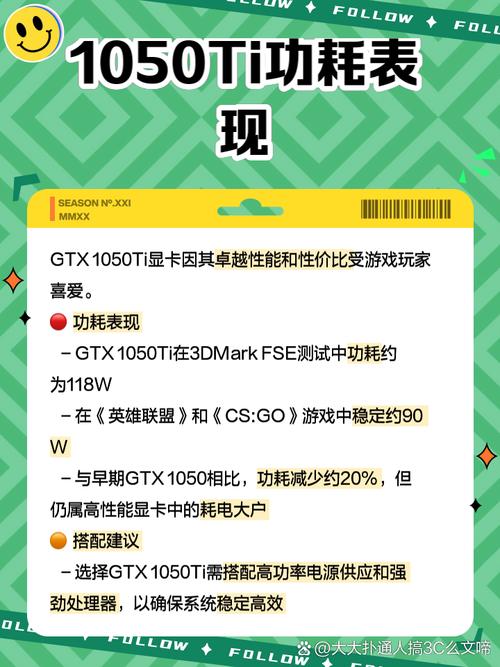

技术不断进步,未来将涌现出更高级的显卡与CUDA技术,然而GTX1050Ti CUDA依然具备其实用价值。对于资金有限的个人开发者和学生来说,它是一个理想的学习和CUDA编程实践工具。然而,它也存在一定的局限,比如显存容量较小,这可能在处理高端计算和大规模数据时遇到瓶颈。在进行复杂的3D建模和渲染,或是大规模神经网络训练的过程中,显存资源往往迅速告罄。

而且,随着技术的进步,显卡的性能需求也在不断提升,GTX1050Ti CUDA可能已经无法满足某些新的计算需求。虽然它能够完成一些基础的科研计算和较小规模的项目开发,但在处理高精度和大规模的科学计算时,它面临一定的挑战。那些曾经使用GTX1050Ti CUDA进行计算任务的朋友们,你们是否遇到过显存不足的情况?